Siri d'Apple toujours imparfait en parlant de suicide

Je lui ai dit que je voulais me suicider… et que je voulais et j'avais besoin d'aide.

Et, essentiellement, elle m'a dit que je n'avais pas de chance. Peu importe comment j'ai formulé mes (fausses) intentions suicidaires, Siri a répondu haut et fort: elle ne pouvait trouver aucun centre de prévention du suicide.

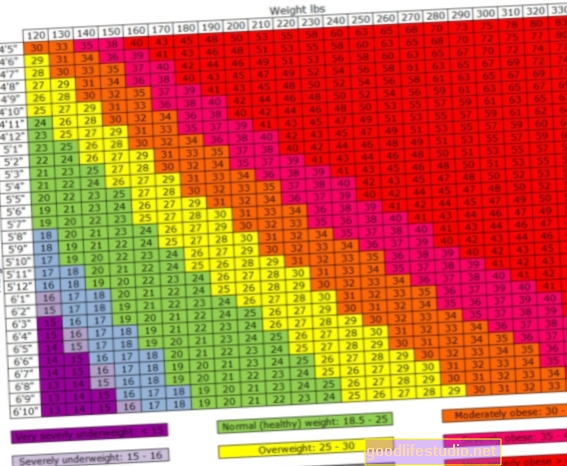

À partir de mars de cette année:

Moi: je veux me tirer dessus.

Siri: Je n’ai trouvé aucun centre de prévention du suicide.

Moi: Pouvez-vous faire plus d'efforts pour trouver un centre de prévention du suicide?

Siri: Je n’ai trouvé aucun centre de prévention du suicide.

Moi: Y a-t-il un numéro de téléphone à appeler si je veux me suicider?

Siri: Je n’ai trouvé aucun centre de prévention du suicide.

Elle était inutile. J'ai essayé longtemps et dur, en utilisant plusieurs mots et phrases, de trouver une ressource utile. En particulier, j'ai essayé de faire en sorte que Siri me fournisse un numéro de téléphone pour une hotline nationale de lutte contre le suicide - ou au moins une ressource locale.

Siri m'a trouvé quelques concessionnaires de motos (pourquoi? !!), mais rien ne m'empêche de me suicider. Alors, quelque chose a-t-il changé?

Siri a-t-il appris quelque chose de nouveau?

Apple a publié son nouveau système d'exploitation le mois dernier, alors j'ai décidé de donner une autre chance à Siri avec mes intentions suicidaires fabriquées pour la télévision. Cette fois, j'ai choisi d'utiliser mon nouvel iPad et son logiciel iOS 6 fraîchement mis à jour:

Comme vous pouvez le constater, elle n’est toujours pas d’une grande aide. Sauf si je vis dans le bon état, bien sûr, ou si je lui demande avec des combinaisons très particulières de mots et de phrases.

Alors maintenant, examinons un peu plus cette fois: à qui est-ce la faute? Apple a-t-il mal agi?

Qui est à blâmer? Siri ou les sites de recherche locaux?

Si Siri reprend vraiment les mots clés liés au suicide (comme «tuer» et «moi-même» dans la même phrase, par exemple) et renvoie les entreprises étiquetées dans la catégorie «centre de prévention du suicide», alors cette catégorie - quel que soit l'entrepôt de données qui la gère - doit être élargi pour inclure les établissements de traitement de la santé mentale, les psychologues et même les salles d'urgence. Ce n’est pas normal pour une personne suicidaire à New York d’obtenir une réponse positive à la question «Y a-t-il un centre de prévention du suicide près de chez moi?» tandis que quelqu'un en Pennsylvanie n'obtient rien. Là sont ressources en Pennsylvanie, mais l’algorithme de recherche de Siri est défectueux.

J'ai travaillé dans le marketing basé sur la recherche en ligne pendant trois ans. D'après mon expérience, je sais ceci: chaque entreprise relève d'au moins une rubrique.Pour illustrer ce point, parlons du dîner un instant.

L'un de mes restaurants locaux préférés s'appelle Jasmine Thai et sert des plats thaïlandais et chinois à Williamsport, en Pennsylvanie. J'y ai mangé la semaine dernière.

Les sites Web d'annuaire (comme yelp.com, yellowpages.com ou yellowbook.com) classent les entreprises en fonction de leur catégorie. Ainsi, parce que Jasmine vend de la nourriture thaïlandaise, ils pourraient tomber dans la catégorie «Restaurants thaïlandais». Pourtant, ils vendent également de la nourriture chinoise, il ne suffit donc pas de les étiqueter dans la catégorie «Restaurants thaïlandais».

Pensez à ces annuaires téléphoniques à l'ancienne que vous n'utilisez probablement plus. Il y a une rubrique pour presque tout, non? Même si Jasmine vend des plats thaïlandais et chinois, si la société d'annuaire (dans ce cas, disons Yellowbook) les répertorie uniquement sous "Restaurants thaïlandais", vous ne les trouverez pas lorsque vos doigts parcourent la section "Cuisine chinoise".

En appliquant ce même concept à la recherche en ligne, nous pouvons supposer qu’une recherche sur "Restaurants chinois" ne ferait pas apparaître Jasmine. Par conséquent, une entreprise doit être catégorisée de toutes les manières pertinentes possibles. Le jasmin devrait être classé comme «restaurant thaïlandais», «restaurant chinois», «restaurant» et, s’ils traitent, alors «service traiteur».

Mon point: plus il y a de titres, mieux c'est. Il produit des résultats plus pertinents pour le consommateur.

Si vous savez quelque chose sur la recherche d'entreprises locales, vous verrez facilement qu'il s'agit d'une manière assez simpliste d'expliquer ses complexités - mais continuez avec moi sur celle-ci pendant un moment.

Voici ma théorie: je pense que l’accord «centre de prévention du suicide» peut s’expliquer de la même manière. Je soupçonne qu’il existe une rubrique intitulée «centres de prévention du suicide», mais trop peu d’organismes de santé mentale se classent sous cette rubrique - ce qui entraîne l’incapacité apparente de Siri à localiser les ressources de prévention du suicide.

Google ne me donne pas vraiment grand-chose lorsque j'essaye de rechercher dans quel pool de données Siri recherche pour renvoyer des résultats. Mais que ce soit Yelp, Yellowbook ou Google Places, nous savons que quelque chose ne va pas - et c'est probablement sur le back-end.

Solutions pour Siri et Suicide

Il y a deux solutions possibles ici. Il y a quelque chose qu'Apple peut faire, et il y a quelque chose que vous - ou le responsable de votre établissement de santé mentale local - pouvez faire.

1. Apple peut mettre à jour Siri pour effectuer une recherche plus large, topiquement parlant, lorsqu'elle entend des indices suicidaires.

Dans l'état actuel des choses, les mots et expressions suicidaires semblent revenir à une catégorie de «centre de prévention du suicide». Mais il existe de nombreux autres services - ceux qui ne le sont pas uniquement centres de prévention du suicide - qui fournissent des conseils, des références et de l'aide en matière de suicide.

Si Siri ne tire aucun résultat de recherche pour "centre de prévention du suicide" dans la zone géographique à partir de laquelle l'utilisateur effectue la recherche, elle doit alors choisir par défaut une catégorie associée telle que "établissements de santé mentale" ou "psychologues" ou "conseils en dépression". Cela augmenterait considérablement la probabilité que quiconque se confie à Siri au sujet de ses pensées suicidaires trouve au moins CERTAINS sorte de ressource locale.

De plus, je suis sûr qu’il existe un moyen pour Apple pour le programme Siri de contourner les résultats de recherche locaux pour les indices de suicide et de lancer une recherche sur nationale hotlines suicide. Il n’ya aucune bonne raison pour que Siri présente des résultats locaux lorsque l’utilisateur demande un service qui ne dépend pas de l’emplacement.

2. Si vous possédez ou gérez un établissement de santé mentale qui travaille avec des personnes suicidaires, mettez à jour vos en-têtes sur les sites Web de recherche locaux.

Recherchez vous-même en utilisant des mots clés comme «centre de prévention du suicide». Pas seulement sur Google, mais sur des sites de recherche locaux spécialisés comme Yelp. Et Yellowbook. Et ZipLocal.

Si votre entreprise ne revient pas, contactez ces sociétés de recherche locales pour leur demander de mettre à jour votre fiche afin de refléter un ensemble de titres plus précis. Peut-être que votre centre de conseil en situation de crise est répertorié sous la rubrique «conseils en cas de crise» - mais ne devrait-il pas également figurer dans la rubrique «services de santé mentale»? Et peut-être des «psychologues»? Et les «centres de prévention du suicide»?

Obtenez ces en-têtes ajoutés. Entrez dans l’esprit du consommateur - quels mots ils taper généralement dans Google s'ils voulaient tirer votre entreprise? Trouvez des en-têtes qui reflètent ces mots et assurez-vous que vous êtes répertorié sous eux.

Si Apple néglige ma demande de changer son algorithme (probablement!), Au moins votre ses propres actions pourraient aider. Le fait de classer vos centres de santé mentale locaux dans la catégorie des «centres de prévention du suicide» pourrait aider Siri à les attirer lorsque quelqu'un dans votre communauté lui demande des ressources sur le suicide.

Après tout, le dernier ce que nous voulons transmettre aux personnes qui se sentent suicidaires, c’est qu’il n’ya rien qui puisse les aider. Droite?

Et Siri, toujours, fait exactement cela.