À l’écoute de «l’effet cocktail» dans le cerveau

Certaines personnes peuvent se concentrer sur un seul haut-parleur malgré un environnement environnant qui obscurcit la voix d'une personne. Le cadre peut être une salle de classe, un bar ou un événement sportif - la capacité n'est pas unique et a été décrite par les psychologues comme «l'effet de cocktail».

Un nouvel effort de recherche dirigé par un neurochirurgien de l'Université de Californie à San Francisco et un stagiaire postdoctoral s'est concentré sur la découverte du fonctionnement de l'audition sélective dans le cerveau.

Edward Chang, M.D., et Nima Mesgarani, Ph.D., ont travaillé avec trois patients qui subissaient une chirurgie cérébrale pour une épilepsie sévère.

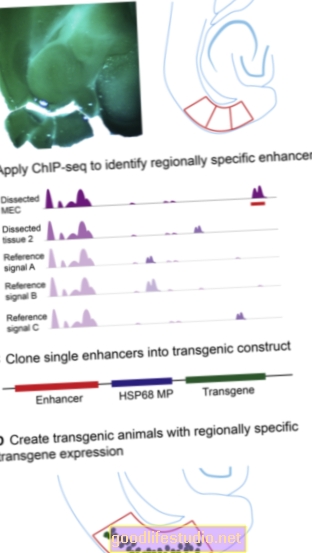

Une partie de cette chirurgie consiste à identifier les parties du cerveau responsables de la désactivation des crises. Cet exercice consiste à cartographier l’activité du cerveau sur une semaine, avec une fine feuille de 256 électrodes au maximum placée sous le crâne sur la surface externe ou le cortex du cerveau. Les électrodes enregistrent l'activité dans le lobe temporal - qui abrite le cortex auditif.

Chang a déclaré que la capacité d'enregistrer en toute sécurité des enregistrements intracrâniens offrait des opportunités uniques pour faire progresser les connaissances fondamentales sur le fonctionnement du cerveau.

«La combinaison d’enregistrements cérébraux haute résolution et de puissants algorithmes de décodage ouvre une fenêtre sur l’expérience subjective de l’esprit que nous n’avons jamais vue auparavant», a déclaré Chang.

Dans les expériences, les patients ont écouté deux échantillons de parole joués simultanément dans lesquels différentes phrases étaient prononcées par différents locuteurs. On leur a demandé d'identifier les mots qu'ils avaient entendus prononcés par l'un des deux orateurs.

Les auteurs ont ensuite appliqué de nouvelles méthodes de décodage pour «reconstruire» ce que les sujets ont entendu en analysant leurs schémas d'activité cérébrale.

De manière frappante, les auteurs ont constaté que les réponses neuronales dans le cortex auditif ne reflétaient que celles du locuteur ciblé. Ils ont découvert que leur algorithme de décodage pouvait prédire quel locuteur et même quels mots spécifiques le sujet écoutait en fonction de ces modèles neuronaux. En d’autres termes, ils pouvaient dire quand l’attention de l’auditeur se détournait vers un autre orateur.

«L'algorithme fonctionnait si bien que nous pouvions prédire non seulement les réponses correctes, mais aussi même lorsqu'ils prêtaient attention au mauvais mot», a déclaré Chang.

Les nouvelles découvertes montrent que la représentation de la parole dans le cortex ne reflète pas seulement l'ensemble de l'environnement acoustique externe, mais plutôt ce que nous voulons ou avons vraiment besoin d'entendre.

Ils représentent une avancée majeure dans la compréhension de la manière dont le cerveau humain traite le langage, avec des implications immédiates pour l'étude de la déficience au cours du vieillissement, du trouble déficitaire de l'attention, de l'autisme et des troubles d'apprentissage du langage.

De plus, Chang dit que nous pourrions un jour être en mesure d'utiliser cette technologie pour des dispositifs neuroprothétiques pour décoder les intentions et les pensées de patients paralysés qui ne peuvent pas communiquer.

Une compréhension de la façon dont nos cerveaux sont câblés pour favoriser certains signaux auditifs par rapport à d'autres peut encourager de nouvelles approches pour automatiser et améliorer la façon dont les interfaces électroniques activées par la voix filtrent les sons afin de détecter correctement les commandes verbales.

La méthode par laquelle le cerveau peut se concentrer si efficacement sur une seule voix est un domaine d'intérêt majeur pour les entreprises qui développent des appareils électroniques avec des interfaces vocales actives.

Si les technologies de reconnaissance vocale qui permettent des interfaces telles que Siri d’Apple ont parcouru un long chemin au cours des dernières années, elles sont loin d’être aussi sophistiquées que le système vocal humain. Par exemple, une personne moyenne peut entrer dans une pièce bruyante et avoir une conversation privée avec une relative facilité - comme si toutes les autres voix de la pièce étaient étouffées.

La reconnaissance vocale, a déclaré Mesgarani, un ingénieur ayant une formation en recherche sur la reconnaissance vocale automatique, est «quelque chose dans lequel les humains sont remarquablement doués, mais il s'avère que l'émulation par machine de cette capacité humaine est extrêmement difficile.

L'article de recherche apparaît dans la revue La nature.

Source: Université de Californie, San Francisco (UCSF)