En savoir plus sur la tristement célèbre étude Paxil 329

Dans une rare révélation en coulisses (en raison d'un procès), le public voit pour l'une des premières fois le degré et la profondeur auxquels certaines sociétés pharmaceutiques se tourneront pour publier des résultats positifs sur leur médicament. Utiliser le même processus d'examen par les pairs qui est censé empêcher les abus des chercheurs et des sociétés pharmaceutiques et fournir aux autres professionnels (et au public) des données objectives. Et le même processus d'examen par les pairs utilisé par la Food and Drug Administration (FDA) des États-Unis pour approuver les médicaments comme étant sûrs et efficaces.

CL Psych nous fournit une analyse plus approfondie de l'étude Paxil 329, une où apparemment les chercheurs se sont donné beaucoup de mal pour trouver l'efficacité. Pourquoi le réexamen de cette étude?

Parce qu'une autre étude vient d'être publiée dans le Journée internationale des risques et de la sécurité en médecine. La nouvelle étude a examiné les documents internes, l'ensemble de données complet et les brouillons publiés dans le cadre d'un procès contre les fabricants de Paxil. Les constats accablants de la nouvelle étude?

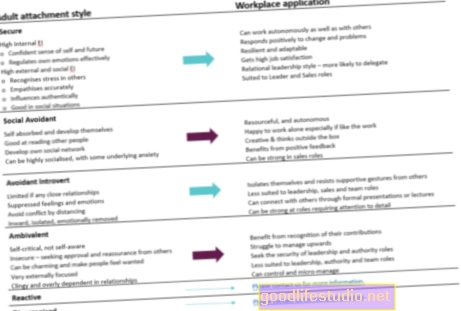

5.1. Les résultats de l'étude 329 étaient-ils positifs ou négatifs?

Il n'y avait pas de différence d'efficacité significative entre la paroxétine et le placebo sur les deux critères de jugement principaux ou six critères de jugement secondaires dans le protocole d'origine. Au moins 19 résultats supplémentaires ont été testés. L'étude 329 était positive sur 4 des 27 résultats connus (15%). Le taux d'EIG était significativement plus élevé avec la paroxétine qu'avec le placebo. Par conséquent, l'étude 329 était négative pour l'efficacité et positive pour les dommages.

5.2. Des rapports sélectifs ont-ils eu lieu?

Les allégations selon lesquelles la paroxétine était «généralement bien tolérée et efficace» découlaient de la notification sélective des 15% de résultats positifs et sélectifs lors de la notification des autres résultats d'efficacité et d'EIG. Le document du JAACAP a été défendu au motif que les lecteurs pouvaient lire dans le tableau des résultats que les deux résultats décrits comme primaires ailleurs (mais pas dans ce tableau) étaient négatifs.

Cependant, les lecteurs sont plus susceptibles d'être influencés par le résumé que par les tableaux d'un rapport d'essai clinique, comme en témoigne la retransmission continue de la fausse impression que l'étude 329 a trouvé «une efficacité significative sur l'un des deux critères d'évaluation principaux». Une cause probable de ce malentendu est la confusion entre «rémission» et «répondeur» et en particulier la fausse déclaration selon laquelle «la paroxétine s'est séparée statistiquement du placebo au point final parmi 4 des paramètres: [y compris] la réponse (c'est-à-dire le critère de jugement principal). . . ».

En d'autres termes, les chercheurs ont soigneusement sélectionné les données pour ne présenter que les données de l'étude publiée qui étaient les plus favorables au médicament qui a payé l'étude - Paxil. Cela montre à peu près le trou béant majeur du processus d’évaluation par les pairs: les revues ne peuvent poser des questions que sur ce qu’on leur dit. Si les chercheurs cachent la véritable conception d'une étude (ou des données négatives), les revues auront une image biaisée. Et puis publiez avec bonheur une telle image complètement inconsciente de la vérité.

Une autre découverte surprenante est que l’étude n’a pas été rédigée par les auteurs répertoriés. Il a été rédigé par une personne ayant une maîtrise. Vous n'avez pas besoin de chercher plus loin que le premier brouillon pour en voir la preuve. Je ne sais pas s'il s'agit d'une procédure opérationnelle standard pour des études de cette taille, mais vous vous attendez à ce que cette paternité soit notée comme dans l'édition traditionnelle.

Vous pouvez tout lire sur la sélection de l'étude 329 sur Healthy Skepticism. Ce qui est effrayant, c'est que personne ne sait à quel point ces types de biais sont répandus dans la recherche publiée. Il s'agit d'une étude parmi des milliers d'études similaires publiées et évaluées par des pairs. D'autres études publiées pourraient-elles souffrir de problèmes similaires? Et si oui, dans quelle mesure la littérature publiée est-elle entachée de ce genre de méthodes sournoises?

Nous ne saurons peut-être jamais.