En développement: des smartphones capables d'évaluer l'humeur

Le programme n’analyse pas ce qu’une personne dit, mais plutôt comment.

«Nous avons en fait utilisé des enregistrements d'acteurs lisant la date du mois - peu importe ce qu'ils disent, c'est la façon dont ils le disent qui nous intéresse», a déclaré Wendi Heinzelman, Ph.D., professeur d'ingénierie électrique et informatique.

Le programme analyse 12 caractéristiques de la parole, telles que la hauteur et le volume, pour identifier l'une des six émotions d'un enregistrement sonore. Les chercheurs affirment qu'il atteint une précision de 81%, une amélioration significative par rapport aux études précédentes qui n'atteignaient qu'une précision d'environ 55%.

La recherche a déjà été utilisée pour développer un prototype d'application qui affiche un visage heureux ou triste après avoir enregistré et analysé la voix de l'utilisateur. Il a été construit par l’un des étudiants diplômés de Heinzelman, Na Yang, lors d’un stage d’été chez Microsoft Research.

«La recherche en est encore à ses débuts», a concédé Heinzelman, «mais il est facile d'envisager une application plus complexe qui pourrait utiliser cette technologie pour tout, du réglage des couleurs affichées sur votre mobile (téléphone) à la lecture de la musique adaptée à la façon dont vous ressens après avoir enregistré ta voix. "

Heinzelman et son équipe collaborent avec les psychologues de Rochester Drs. Melissa Sturge-Apple et Patrick Davies, qui étudient actuellement les interactions entre les adolescents et leurs parents. «Un moyen fiable de catégoriser les émotions pourrait être très utile dans nos recherches», a déclaré Sturge-Apple. «Cela signifierait qu’un chercheur n’aurait pas à écouter les conversations et à saisir manuellement l’émotion de différentes personnes à différentes étapes.»

Apprendre à un ordinateur à comprendre les émotions commence par reconnaître comment les humains le font, selon les chercheurs.

«Vous pourriez entendre quelqu'un parler et penser:" Oh, il a l'air en colère. "Mais qu'est-ce qui vous fait penser cela?" dit Sturge-Apple.

Elle a expliqué que l'émotion affecte la façon dont les gens parlent en modifiant le volume, la hauteur et même les harmoniques de leur discours. "Nous ne prêtons pas attention à ces fonctionnalités individuellement, nous venons juste d'apprendre à quoi ressemble la colère - en particulier pour les personnes que nous connaissons", a-t-elle ajouté.

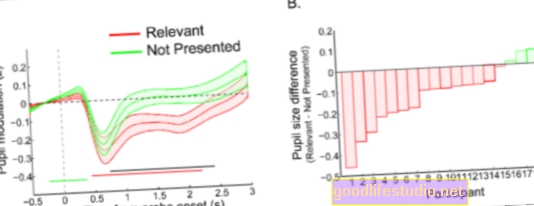

Mais pour qu'un ordinateur catégorise les émotions, il doit fonctionner avec des quantités mesurables. Les chercheurs ont donc établi 12 caractéristiques spécifiques de la parole qui ont été mesurées dans chaque enregistrement à de courts intervalles. Les chercheurs ont ensuite catégorisé chacun des enregistrements et les ont utilisés pour enseigner au programme informatique à quoi ressemble un son «triste», «heureux», «craintif», «dégoûté» ou «neutre».

Le système a ensuite analysé les nouveaux enregistrements et tenté de déterminer si la voix de l'enregistrement représentait l'une des émotions connues. Si le programme informatique était incapable de décider entre deux émotions ou plus, il laissait simplement cet enregistrement non classé.

"Nous voulons être sûrs que lorsque l'ordinateur pense que le discours enregistré reflète une émotion particulière, il est très probable qu'il dépeint effectivement cette émotion", a déclaré Heinzelman.

Des recherches antérieures ont montré que les systèmes de classification des émotions dépendent fortement du locuteur, ce qui signifie qu'ils fonctionnent beaucoup mieux si le système est entraîné par la même voix qu'il analysera. «Ce n'est pas idéal pour une situation où vous voulez pouvoir simplement mener une expérience sur un groupe de personnes qui parlent et interagissent, comme les parents et les adolescents avec lesquels nous travaillons», a déclaré Sturge-Apple.

Les nouveaux résultats confirment ce constat. Si la classification des émotions basée sur la parole est utilisée sur une voix différente de celle qui a entraîné le système, la précision est passée de 81% à environ 30%. Les chercheurs étudient maintenant des moyens de minimiser cet effet en formant le système à une voix du même groupe d'âge et du même sexe.

«Il y a encore des défis à résoudre si nous voulons utiliser ce système dans un environnement ressemblant à une situation réelle, mais nous savons que l'algorithme que nous avons développé est plus efficace que les tentatives précédentes», a déclaré Heinzelman.

Source: Université de Rochester